«Eit kvantesprang for spelarar», sa Nvidia-sjef Jensen Huang då han viste fram sine nye skjermkort i september.

Flaggskipet Nvidia GeForce RTX 4090 er det første produktet som kjem på marknaden i 4000-serien. Skjermkortet er bygd på den nye Ada Lovelace-arkitekturen, som erstattar Ampere-arkitekturen dei neste åra.

Ytinga skulle bli alt frå to til fire gongar så høg som førre generasjon.

Stemmer det?

Nja.

Nvidia har smurd på ganske tjukt under marknadsføringa før lanseringa, men den nye 4000-serien er uansett ein siger for dei pengesterke som vil ha kraftig grafikkyting.

Gamer.no har hatt ei vekes tid til å teste Founder’s Edition-utgåva av RTX 4090.

Skjermkortet er svært, svært kraftig. Og like dyrt.

Denne versjonen kjem sannsynlegvis ikkje til å vere tilgjengeleg for sal i norske butikkar, men det er dette produktet alle tredjepartsprodusentane baserer sine versjonar på.

Svindyrt

Først får me unna det tekniske. Spesifikasjonane. Marknadsføringa i skjermkortverda er i stor grad basert på kven som kan vise til dei største tala, om det så er talet på kjernar, transistorar eller videominne.

Eigentleg er det berre biletefrekvensen, responstid og prislappen som betyr noko for oss spelarar. Me viser difor dette kjapt med ein liten tabell:

| RTX 4090 FE | RTX 3090 Ti | RTX 3090 FE |

CUDA-kjernar | 16 384 | 10 752 | 10 496 |

Videominne | 24 GB GDDR6X | 24 GB GDDR6X | 24 GB GDDR6X |

RT-kjernar | 128 | 84 | 82 |

Tensor-kjernar | 512 | 336 | 328 |

Minnegrensesnitssbreidde | 384-bit | 384-bit | 384-bit |

Straumforbruk | 450 watt | 450 watt | 350 watt |

Boostklokke | 2520 MHz | 1860 MHz | 1695 MHz |

Lanseringspris | 20 490 kroner | ~25 000 kroner | 17 000 kroner |

Ada-arkitekturen er bygd på TSMC sin node på fire nanometer, medan Ampere var basert på Samsung sin node på åtte nanometer. Talet på transistorar er auka frå 28,3 milliardar i RTX 3090 Ti til 76,3 milliardar i RTX 4090.

Det er ei store auke. Men igjen er dette tal som ikkje betyr så mykje for meg og deg.

Nvidia har varsla at Moores lov, den som seier at ein kan doble talet på transistorar og redusere kostnadane annakvart år, er død.

Prisane på skjermkort vil stige.

Høg inflasjon, vanskelege kår for produksjon, tøffare konkurranse frå AMD og forbrukarane sine forventningar om store sprang i gamingyting, gjer at Nvidia tyner lommebøkene våre for å hjelpe eigne marginar og sikre aukande biletefrekvensar.

Dei kjem nok heilt fint ut av det. Folk kjøper produkta likevel.

RTX 4090 kostar mindre enn RTX 3090 Ti, men er frykteleg dyrt. Likevel er det prisnivået på RTX 4080, RTX 4070 og RTX 4060 folk kjem til å irritere seg mest over, ikkje dette.

Det er få som har behov for noko så kraftig som RTX 4090.

Spelyting

Kort sagt; RTX 4090 er eit monster.

Det knuser alt anna på marknaden i 4K og over, og tar ei klar leiing i 1440p.

Vår testbenk

- Prosessor: Intel Core i9-12900k

- Kjølar: Asus ROG Ryujin II 360

- Hovudkort: Asus ROG Maximus Z690 Hero

- Minnebrikker: Kingston Fury Beast 32 GB DDR5-5200 CL40

- Lagring: Kingston Fury Renegade 2 TB M. 2 SSD x2

- Straumforsyning: Asus ROG Thor 1200 watt

- Kabinett: Cooler Master Mastercase H500P Mesh ARGB

- Operativsystem: Windows 11 Pro

Skjermkortet skildrar òg kor langt produsentane har kome dei siste åra. I dag er ikkje dei beste korta noko vits i for 1920x1080-speling, anna enn i dei aller mest krevjande e-sport-spela, der du gjerne har ein 360 hertz eller (etter kvart) 480 hertz skjerm.

Prosessorane er ikkje kraftige nok til å halde følgje lenger.

Mellomklasseskjermkort er uansett meir enn nok i 1080p, og RTX 4090 er meiningslaust om du ikkje skal spele i høgare oppløysingar eller med strålesporing.

Middle-earth: Shadow of Mordor og Assassin's Creed Valhalla er dei einaste spela me har testa der RTX 4090 er klart betre enn konkurransen i 1080p utan strålesporing. Det er først i 1440p at meir av arbeidsmengda blir flytta over på skjermkortet, og RTX 4090 får byrje å briljere.

Mot AMD RX 6950 XT er RTX 4090 i snitt 26 prosent raskare i 1440p og 40 prosent kjappare i 4K.

Mot RTX 3090 er RTX 4090 i snitt 27 prosent raskare i 1440p og 53 prosent raskare i 4K. Desse målingane er utan strålesporing og DLSS. Sistnemnde endrar reknestykket i RTX 4090 sin favør med god margin.

Snittet i biletefrekvens skildrar igjen at ein ikkje treng eit så kraftig skjermkort som RTX 4090, med mindre ein absolutt må spele på ultra-nivå og ha best mogleg yting. Dette er for dei spesielt interesserte.

Samstundes vil nye spel utfordre skjermkorta vidare. Cyberpunk 2077 er det mest krevjande spelet på vår testliste, der RTX 4090 klarar i snitt 77 FPS i 4K.

I løpet av det neste året kjem det garantert noko som RTX 4090 ikkje klarar å køyre over den magiske 60-grensa. Slik er det berre.

Det går i alle fall ein generasjon til før me har eit XX90-kort som tar alt i 4K, uansett kva. Og endå ein generasjon for det same med strålesporing.

Er strålesporing endeleg verd å bruke?

Cyberpunk 2077 har, meiner eg, den flottaste implementeringa av strålesporing nokosinne.

RTX 4090 knuser forgjengaren i spelet.

I 1440p aukar RTX 4090 biletefrekvensen i snitt med 80 prosent i dei ulike testspela våre mot RTX 3090, og i 4K er talet 90 prosent.

I Cyberpunk 2077 aukar ytinga med 110 prosent. Det er mykje.

Slår me av ultra på dei overordna innstillingane, og strålesporinga til eit meir fornuftig nivå, taklar RTX 4090 strålesporing i både 6K og 8K.

Betyr dette at eg kjem til å slå på strålesporing på maks viss eg speler Cyberpunk 2077 i framtida?

Neppe. Eg set pris på høgast mogleg biletefrekvens, og gidd ikkje spele med 40 FPS i 4K. Det er likevel ingen tvil om at strålesporing har eit mykje meir solid fundament enn nokosinne.

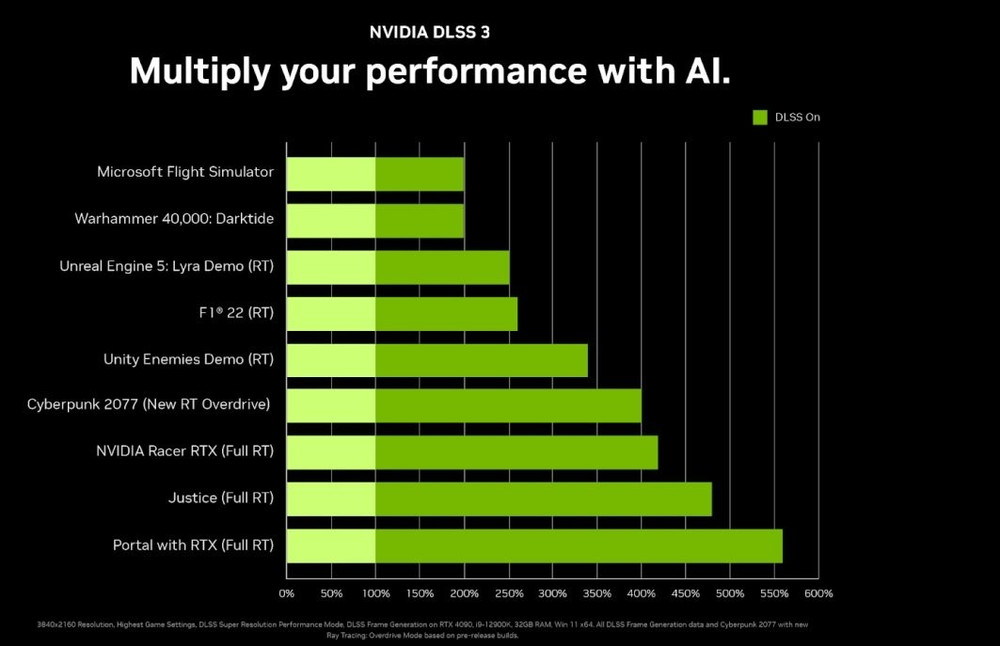

Men så er det DLSS, da. Nvidia sin oppskaleringsteknologi basert på kunstig intelligens. Og den endrar alt.

Ny teknologi

I konkurransen med AMD er DLSS 3.0 esset i ermet til Nvidia.

Det er DLSS 3 Nvidia baserer marknadsføringa si på.

Auka i yting på to til fire gongar skal kome takka vere oppskaleringsteknologien deira. Det syns eg dei burde fått fram betre i presentasjonen sin, men dagens DLSS er ikkje langt unna å vere like bra som korleis ein teiknar spel på vanleg vis.

I nokre spel er det betre.

4000-serien blir dei einaste skjermkorta som får nyte av nye DLSS. Det er irriterande for dei med eldre kort, men eg trur det er like greitt, då det lar Nvidia dra på litt ekstra.

Nvidia omtalar DLSS 3 som ein revolusjon. I staden for å bruke kunstig intelligens til å teikne kvart enkelt piksel, lagar DLSS 3 heile biletet i eitt. Det gir både høgare biletefrekvens og lågare forseinking.

Førversjonen vår av Cyberpunk 2077 med den nye DLSS-modusen har dessverre ikkje fungert, men me har fått testa F1 2022 skikkeleg.

I F1 2022 gir nye DLSS Performance 25 prosent høgare yting enn i DLSS 2.0, og med DLSS Quality får me 13 prosent høgare yting.

DLSS Performance gir oss i snitt 219 FPS i 4K, utan at eg merkar noko særleg til lågare kvalitet. 219 FPS. I eit heilt nytt spel.

Ein revolusjon er det kanskje ikkje, men viss nok spel får støtte for DLSS 3.0, veit eg ikkje heilt korleis AMD kan svare. FSR er ikkje i nærleiken av like bra som DLSS, og no blir skilnaden endå større.

Den nye teknikken kan til og med hjelpe i spel der prosessoren er flaskehalsen.

Det er ein heil haug med spel som får DLSS 3 no i oktober, og dei som ikkje har 4000-serien får blant anna tilgang til DLSS 2 og Nvidia Reflex i desse spela.

DLSS 3 er svært lovande.

Me får sjå kor stor forskjell det blir i dei andre spela, men om F1 2022 gir ein peikepinn, så får me veldig mykje gratis her. Eg trur me kjem til å sjå mange fleire spel implementere støtte for DLSS med resultat som dette.

DLSS har me ikkje fått på langt nær nok tid til å undersøke før sperrefristen for testen, så her kjem me tilbake med ein featureartikkel i framtida.

Straumforbruk og temperatur

RTX 4090 Founders Edition er gigantisk. Kortet er utan tvil det største eg har sett, og tar opp tre rekker i kabinettet mitt. Det veg nesten 2,2 kilo.

Dei med små kabinett kan berre gløyme å få plass til det. Eg har ikkje prøvd nokon av tredjepartskorta, men det er sikkert fleire av dei med høgare klokkehastigheit som er betydeleg større.

Kortet bøyer seg ikkje sjølv om det veg så mykje, så storleiken er ikkje noko problem så lenge du har eit romsleg kabinett.

Kjølinga er det lite å seie på. 72 grader er det meste skjermkortet har vore oppe i under full last den siste veka. Minnetemperaturen har maks vore på 78 grader og «hot spot»-temperaturen på 81 grader. Sistnemnde er klart mindre enn førre generasjon.

Vifta høyrer eg ikkje i det heile over AIO-kjølaren på prosessoren min. På det meste har vifta spunne opp til 1486 omdreiingar i minuttet, men det med eit støynivå på maks 37 desibel i ein open testrigg.

Dei som speler med lukka kabinett kjem ikkje til å høyre det.

Nvidia anbefaler ei straumforsyning på minst 850 watt for RTX 4090. Utan å overklokke har ikkje kortet dratt meir enn 420 watt frå veggen, og har boosta heilt opp til 2750 MHz. Slik sett er ikkje det så veldig vits i å overklokke.

Produsenten seier at ein berre treng tre PCIe-straumkontaktar med åtte pinnar for å gi det nok straum, men du kan plugge inn fire viss du vil overklokke.

RTX 4090 FE har den nye femtegenerasjons straumkoplinga med 12 pinnar.

Du får med adapter viss du ikkje har ei straumforsyning med ein slik, noko dei færraste har, då desse kom i år. For dei som har straumforsyning med den siste generasjonen kontaktar, får ein velje mellom å plugge inn ein på 450 watt eller ein på 650 watt.

Overklokking

Det er mange år sidan manuell overklokking har vore verd den korte tida det tar.

Alle skjermkorta til Nvidia klokker automatisk opp viss dei har moglegheit for det, og manuell overklokking kan i mange tilfelle føre til lågare yting. Det gjeld spesielt når ein overklokkar minnet.

Det ser ikkje ut til å ha endra seg nemneverdig. Klokkehastigheita er allereie skyhøg ut av eska, men eg klarte å løfte ho 175 MHz til med manuell overklokking.

Minneklokkehastigheita kunne eg auke med 1,5 GHz. Dessverre gir det ikkje all verda med effekt. I dei syntetiske testane til 3DMark er forskjellen ganske stor, men i spel gir det forsvinnande lite utslag.

Eg fekk tre prosent høgare biletefrekvens i Cyberpunk 2077, fire prosent i Far Cry 5 og to prosent i Middle-earth: Shadow of War.

Straumforbruket gjekk opp med rundt 40 watt. Det er med andre ord like greitt å berre la kortet styre dette sjølv.

Var ting betre før?

Før me rundar av, må eg lufte litt irritasjon rundt prisen på skjermkort.

I løpet av det siste tiåret var det 1000-serien, altså Pascal-arkitekturen frå 2016, som bydde på det største hoppet i yting. GTX 1080 gav ei auke i biletefrekvens på rundt 50–60 prosent samanlikna med GTX 980.

GTX 1080 kosta derimot 7600 kroner. Prisen frå GTX 980 til GTX 1080 auka med 65 prosent. GTX 1080 Ti kom seinare til same pris som veslebroren, men så auka prisane vidare.

Turing-arkitekturen gav klart mindre for pengane. RTX 2080 kosta 8500 kroner, to år seinare, og var knapt meir kraftig enn GTX 1080 Ti.

RTX 2080 Ti kosta 12 700 kroner.

Ampere blei det neste store hoppet i yting, der RTX 3080 gav oss rundt 50 prosent betre yting samanlikna med RTX 2080. Problemet har seinare vore at prisane gjekk amok, og lanseringsprisen til rundt 8–9000 kroner har vore eit reint kupp i seinare tider.

Dei fleste RTX 4090-versjonane kostar nok godt over 20 000. Til gjengjeld er 90-serien for dei hardbarka entusiastane, og har aldri handla om å gi mest mogleg for pengane.

Det viser både prisen og ytinga samanlikna med veslebrørne i tidlegare generasjonar.

Konklusjon

Nvidia GeForce RTX 4090 FE er ein maktdemonstrasjon. Det er tilnærma lydlaust, over 50 prosent kraftigare enn RTX 3090 og den nye generasjonen DLSS byr på ei drastisk auke i biletefrekvens oppå dette igjen.

Spe på med snacks som ein meir effektiv videokodek, betre støtte for Nvidia Reflex (som minskar forseinking i spel) og eit styrka Nvidia Broadcast for dei som driv med streaming, så har du ein uslåeleg miks for spelarar.

I praksis kan du spele alt du vil med akseptabel biletefrekvens i 4K. Med DLSS og litt justering på innstillingsmenyen kan du til og med kople maskinen til ein 8K-TV og spele med god flyt.

Problemet er naturlegvis kor elendig valuta du får for pengane dine. XX90-korta til Nvidia er laga for entusiastar, og det blir stadig dyrare å vere entusiast.

Over 20 000 kroner for eit skjermkort er spinnvilt. Heldigvis har dei aller fleste null behov for eit så kraftig skjermkort som dette. Men har du råd og lyst, så køyr på.

Eg vil veldig gjerne sjå at AMD banker Nvidia ned i støvlane med sine nye produkt for konkurransen sin skuld, men eg klarar ikkje sjå for meg at det er mogleg.

RTX 4090 er for kraftig.