Turing-plattforma til Nvidia har vore høgst omdiskutert. Ny teknologi som «raytracing» og «DLSS» har flytta grensene for kva grafikk me kan få i spel, men prisen på produkta har gått i taket. Samstundes er forskjellane i ytinga samanlikna med Pascal-korta skuffande. Der hoppet frå 900- til 1000-serien gav reine kvantesprang i biletefrekvens, er det langt mindre å hente denne gongen.

Her er det med andre ord pluss og minus. Me har difor tenkt å kikke litt nærmare på dei nye korta, og kjem til å publisere testar av heile RTX-produktserien til Nvidia framover. Som skribent for Gamer.no vil sjølvsagt mitt fokus ligge på bruken i spel, og dersom du har dataspel som du ønskjer at me skal teste korta i, er det berre å rope ut i kommentarfeltet. Me kjem ikkje til å skrive noko om yting knyta til arbeidsoppgåver som rendering og liknande her.

Me byrjar testserien vår på toppen, med flaggskipkortet Nvidia RTX 2080 Ti. Denne testen vil difor både reflektere litt i breidda rundt Turing-lanseringa, samstundes som me vil vurdere korleis kortet me bruker – Gigabyte GeForce RTX 2080 Ti Gaming OC – fungerer når det kjem til overklokking, temperaturar, straumbruk og liknande. Sjølve testen av det kortet byrjar på neste side i artikkelen, og så vil de finne alt av testar i spel på side tre.

Først av alt vil me ta ein kikk på dei teknologiske framstega som har kome med Turing-lanseringa.

Følg denne lenkja for å gå rett til testen »

Strålesporing

2018 sitt fremste buzzword i teknologiverda har definitivt vore «raytracing», eller strålesporing som det heiter på norsk. Teknikken er langt frå ny, men fram til no har ikkje skjermkort vore i stand til å bruke strålesporing i sanntid – i alle fall ikkje utan enorme tap i yting.

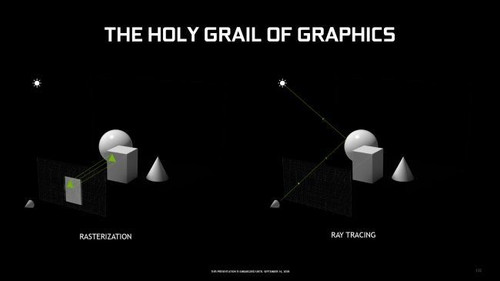

Strålesporing er ein algoritme som kan simulere korleis ei lysstråle vil oppføre seg med å spore den frå opphav, og vidare langs alt den reflekterer på. Sjå for deg at strålen frå ei lommelykt treff ein vegg i komplett mørkre. Ein tenkjer kanskje ikkje på det, men sjølv då vil veggen reflektere lys og kaste lyssstrålar i alle retningar rundt i resten av rommet. Strålesporing lar oss gjere det same virtuelt. Når det kjem til spel, betyr dette at me kan forbetre korleis tradisjonell «rendering» viser lys. Vanlegvis skjer dette via såkalla «rasterization» som tar nokre snarvegar for å kutte kostnadane på yting, men no er det mogleg å vise fullverdig strålesporing i sanntid takka vere ein hybrid av «rasterization», strålesporing, AI og simulering. Lyssetting av områder i spel vil verke meir realistiske basert på kvar lyskjelda kjem frå, samt at skuggar og refleksjonar vil få meir liv.

Nvidia omtalar strålesporing som «den heilage gral» av grafikkteknologi. For den gjennomsnittlege dataspelaren vil det neppe vere så viktig i første omgang, men resultatet er at spel som Battlefield V har fått tilnærma fotorealistiske refleksjonar på reflekterande overflater.

Eg skreiv ein del om strålesporing i Metro Exodus for ei stund sidan, der teknikken har gjort mykje for å legge eit ekstra lag på det allereie teknologisk imponerande spelet. Likevel er det ei stund til det er verd å slå på innstillinga slik den er no, for resultatet går hardt utover biletefrekvensen i spela det er kome til. De kan sjå RTX 2080 Ti-resultata nedst på tredje side av denne saka.

Shadow of the Tomb Raider viste òg fram nokre flotte bilete av teknikken i action i fjor, som endeleg kom i ei oppdatering i slutten av mars. Der Metro Exodus brukar strålesporing for lys, og Battlefield V brukar det til refleksjonar, har Shadow of the Tomb Raider berre strålesporing på skuggar. Forskjellen er der, men det er merkbart mindre enn i dei andre spela.

Auka yting med «DLSS»

Strålesporing i sanntid er mogleg takka vere «RT cores». Dette er dedikerte kjernar i skjermkortet som jobbar med teknikken. RTX-korta har òg fått nokre andre nye kjernar, nemleg «Tensor cores». Desse kjernane har me tidlegare sett i blant anna arbeidsstasjonskort som Tesla V100 og Titan V, men er no å finne i forbrukarserien. Tensor-kjernane er basert på maskinlæring, og brukast til å effektivisere kunstig intelligens.

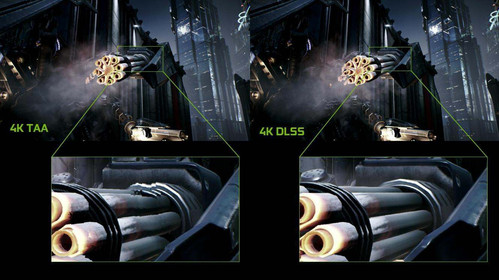

Det som er mest viktig når det kjem til speling her, er såkalla «Deep Learning Super-Sampling». Dette er ein hybrid av super-sampling og kantutjamning, som takka vere Tensor-kjernar kan teikne eit spel i høgare oppløysing utan den store negative effekten på yting som super-sampling vanlegvis har.

Nvidia har satt kunstig intelligens til å teikne dei same bileta om og om igjen, milliardar av gongar, for å lære eit nevralnettverk korleis det kan gjette seg fram til utsjånaden til biletet. Dette vil gjere det mogleg for dette nevralnettverket å simulere korleis eit spel skal sjå ut i 4K, samstundes som ytinga vil vere på nivå med å spele i 1440p. I alle fall i følgje Nvidia.

Denne teknikken må implementerast i eitt og eitt spel, men Nvidia har gitt tilbod om å hjelpe utviklarane med dette i første omgang. Førebels er det berre Final Fantasy XV, Anthem, Battlefield V, Metro Exodus og Shadow of the Tomb Raider ein kan prøve dette i, men teknikken kan bli ekstremt nyttig etter kvart som den får meir støtte. De kan sjå resultata i ytingstestar på side tre for dei to siste spela.

Det visuelle resultatet av DLSS har vore litt skuffande fram til no, men oppdateringar frå Nvidia og utviklarane gjer teknikken betre og betre. Ein kan anta at DLSS vil kunne lære kjappare etter kvart, slik at ein slepp å vente over eit halvt år på oppdateringar som i Shadow of the Tomb Raider.

Shadow of the Tomb Raider har så langt bydd på det beste resultatet med ei monaleg auke i yting, og mindre fall i biletekvalitet enn i dei andre spela. Det er framleis lett å sjå forskjellen – spesielt på detaljar i distansen –, men i farta er det usannsynleg at ein vil tenkje noko særleg over saka.

Turing for folk flest?

No som me har fått prøve både strålesporing og DLSS i nokre ulike spel, er det klart at Nvidia ikkje heilt har levert. Lovnaden frå Nvidia om at biletekvaliteten med DLSS ville vere på same nivå som TAA er definitivt ei sanning med modifikasjonen. Du får eit mjukare bilete med mindre detaljar, spesielt i lågare oppløysingar (som du ikkje ein gong kan bruke DLSS i med 2080 Ti på grunn av at det ikkje er hensiktsmessig å bruke DLSS for høg biletefrekvens).

Strålesporing har heller ikkje vore heilt den suksessen som Nvidia såg for seg. Teknikken kjem med eit monaleg dropp i yting, som forbrukarane ikkje har vore spesielt nøgde med. Men igjen er dette heilt ny teknologi.

DLSS og strålesporing har vore dei to store seljepunkta for den nye serien, og er grunnen til at Nvidia kan prise korta sine langt høgare enn før. Kombinasjonen av dette og oppgradering til GDDR6-minne samt ei massiv auke i brikkestorleik samanlikna med GTX 1080 Ti, har ført til at dei fleste modifiserte RTX 2080 TI-korta ligg rundt 12 000 – 13 000 kroner. Det er mykje pengar. Nesten 5 000 meir enn GTX 1080 Ti lanserte til, faktisk. Her ligg nok ein stor del av forklaringa for kvifor folk er ganske skuffa over dei nye Turing-korta. Dei er rett og slett for dyre.

Generelt sett har ytinga til 2080 Ti lagt seg rundt 30 prosent over 1080 Ti, og dei fleste vil neppe sjå på det som god nok grunn til å bla opp over 10 000 kroner. Der hoppa i yting frå GTX 980 til GTX 1080, og GTX 1080 til 1080 Ti var langt større, er fokuset her delvis endra. Nvidia har allereie 4K-kort å by på, og har tatt sjansen på å gi spelarane noko ekstra. For min del, og sikkert dei fleste andre «vanlege» forbrukarar», ville eg heller hatt betre yting og ingen strålesporing, men dette måtte kome før eller seinare.

Det er ingen tvil om at ny teknologi kostar mykje. Eg trur ikkje det er så mange som eigentleg har behov for eit RTX 2080Ti-kort, heller. Sjølv mellomklassekort frå førre generasjon vil vere nok for dei fleste som speler i 1080p. Konkurransen frå AMD i toppsjiktet er framleis ikkje-eksisterande, og Nvidia har eit jerngrep rundt marknaden. Det nye AMD-kortet lanserte til same pris som RTX 2080 med omtrent den same ytinga, men kjem utan moglegheit for DLSS og strålesporing. Ikkje minst har no Nvidia opna for å la brukarane sine dra nytte av FreeSync og Adaptive-Sync, som fjernar behovet for dyre G-Sync-skjermar. For augeblikket er det eigentleg liten grunn til å velje noko anna enn Nvidia så lenge ein er mest opptatt av dataspeling med toppskjermkort. Det hadde vore kjekt å sjå meir konkurranse her, men førebels er det lite som tyder på at det kjem til å kome med det første.

Med det avsluttar me synsinga mi om Turing-lanseringa, og går over på det me verkeleg er interessert i: Testing og benchmarking. Les vidare på neste side for domen over Gigabytes RTX 2080 Ti GAMING OC-skjermkort.

På side tre finn de biletefrekvens-testar i ti ulike spel, der me samanliknar RTX 2080 Ti opp mot eit ASUS Rog Strix GTX 1080Ti, og eit ASUS 1080 referanse-kort. Testmaskina vår har køyrt med ein Intel Core-i7 8700K klokka til 4,9 GHz, og 16 GB DDR4-RAM stilt til 3 GHz.

Klikk her for å gå vidare til neste side og lese test av Gigabyte Geforce RTX 2080 Ti Gaming OC »